前言

目前自部署或者自己安装开源ChatUI来使用LLM的人可能不多,主要集中在有主动调用LLM供应商API或自部署的有LLM的人群,因此来看该文章的人我是默认你知道怎么调用API来使用LLM的,故在如何调用这一块我不会再进行其他赘述,本文将集中在同一个API与模型下哪一个ChatUI的使用体验最好。

下文中提到的ChatUI均为开源且可免费部署使用的。

LLM供应商:火山引擎

模型:Deepseek V3和Deepseek R1

评测标准

本文将主要从以下8个角度来评测一个ChatUI:

API 接入: 评估接入的简易程度。

模型配置: 评估模型选择和配置的便捷性。

部署方式: 评估部署的难易程度。

联网能力: 是否支持联网。

知识库: 是否支持接入知识库。

数据同步: 是否支持多端数据自动同步。

跨平台: 是否支持任意客户端访问。

插件: 是否支持插件扩展。

下面是结果表格,按排名进行排序:

建议看完本文再根据表格进行选择,否则容易踩坑,同时在文章的末尾也提供了建议来辅助选择一个ChatUI。

下文中提到的ChatUI中除了NextChat以外都是支持R1的思考展示的。

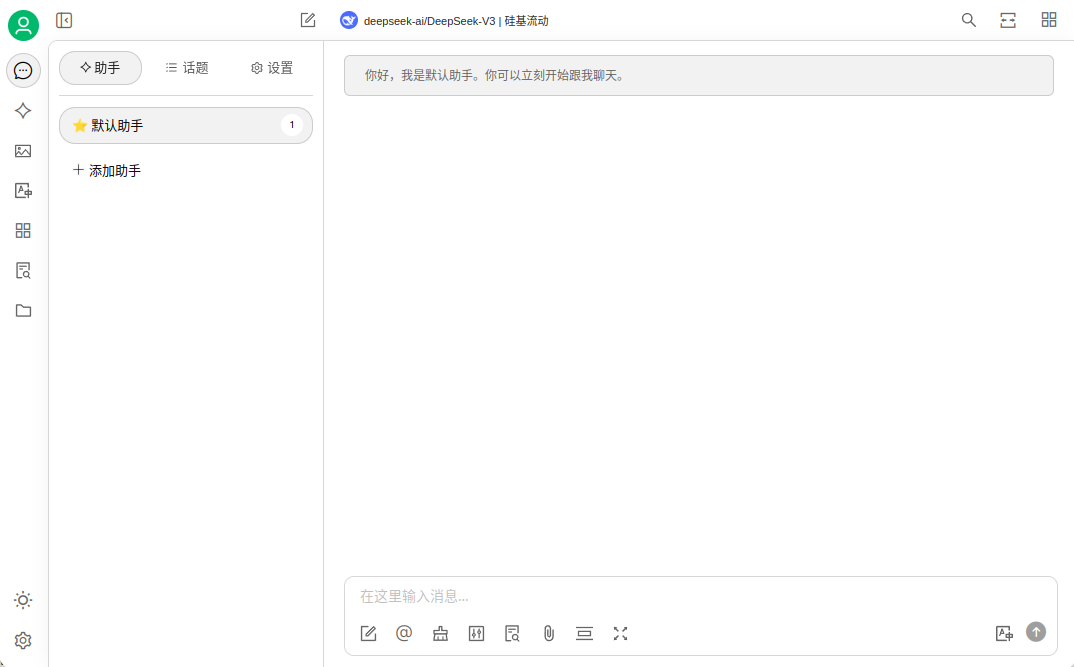

LobeChat-Database

LobeChat-Database

API接入:🟢

模型配置:🟢

部署方式:🔴

联网能力:🟢

知识库:🟢

数据同步:🟢

跨平台:🟢

插件:🟢

LobeChat-Database是一个跨端、支持插件、支持自定义模型供应商以及支持多格式知识库的ChatUI。

为什么我把它放在第一呢?就因为它功能实在是太全了——主要功能除了代码解释器以外就不差了。

而且UI好看。

分支对话、知识库和联网也都是支持的,不过后联网需要使用插件来实现,好在也有提供官方的插件。

以及用户管理也是支持的。

而且市面上的绝大部分供应商也是支持的。

当然缺点也是有的——Lobechat-Database实在是过于难部署,官方文档写的疑似是不想让人部署LobeChat-Database而是去用官方的8刀一个月的同步。

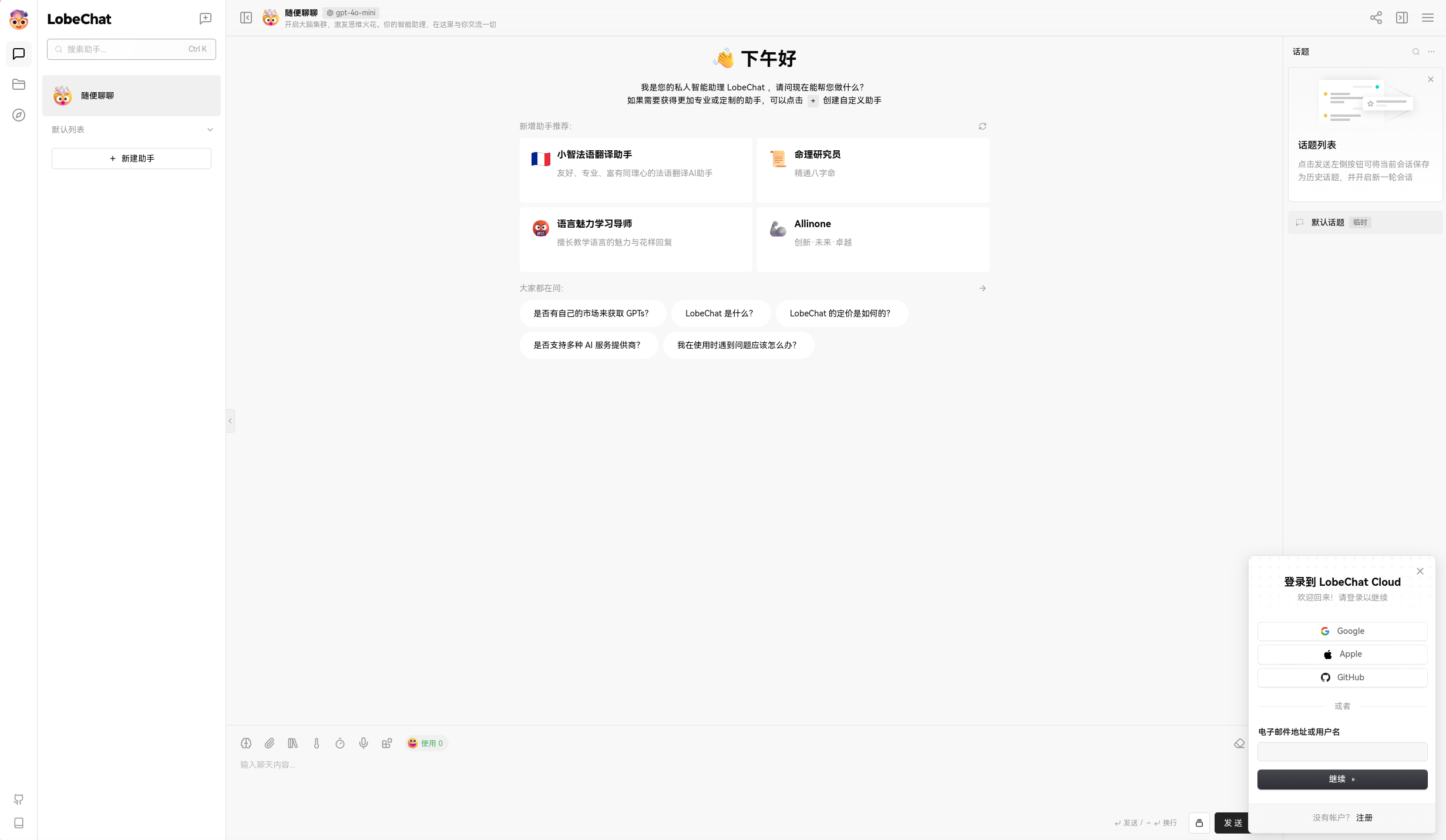

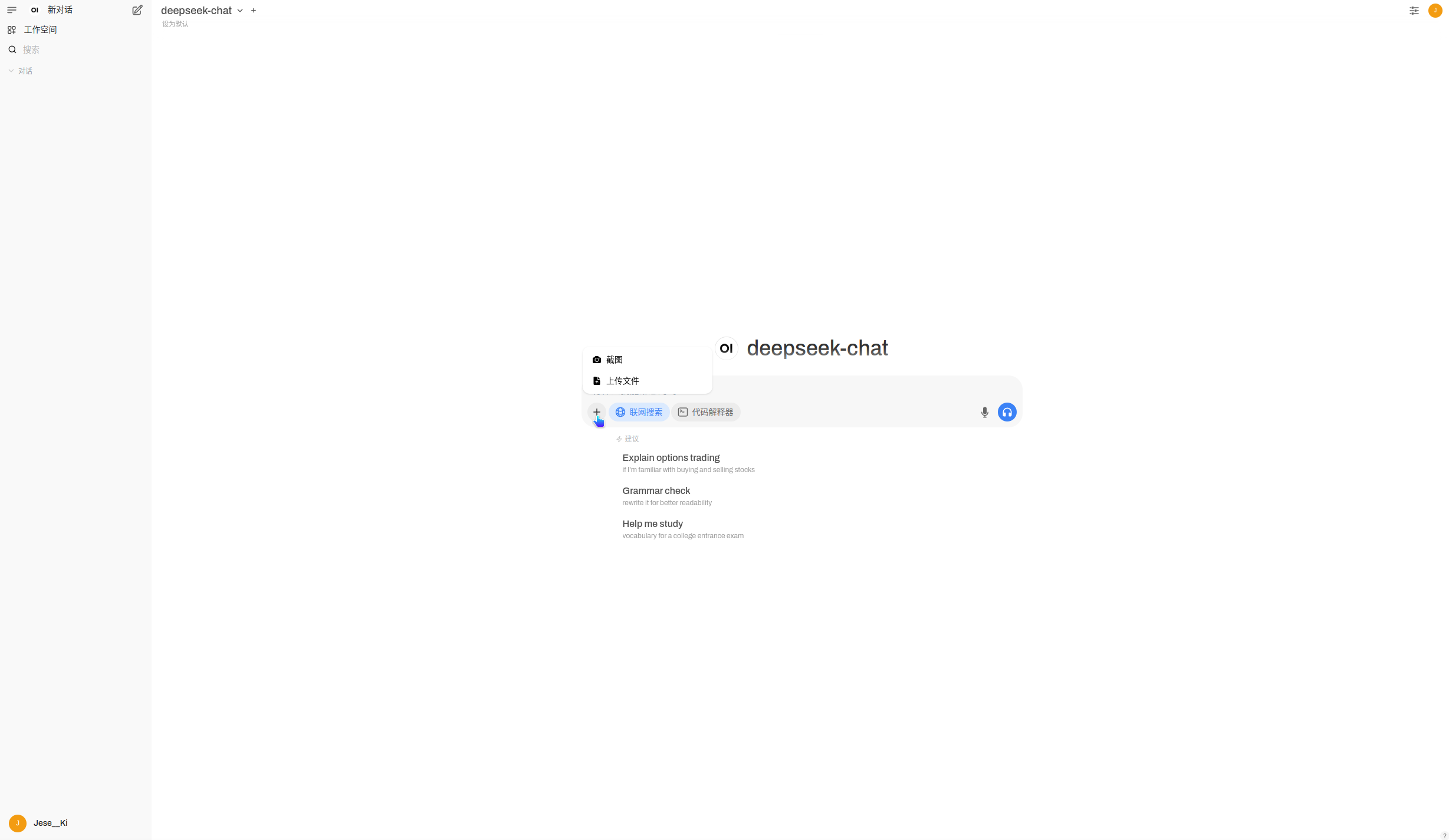

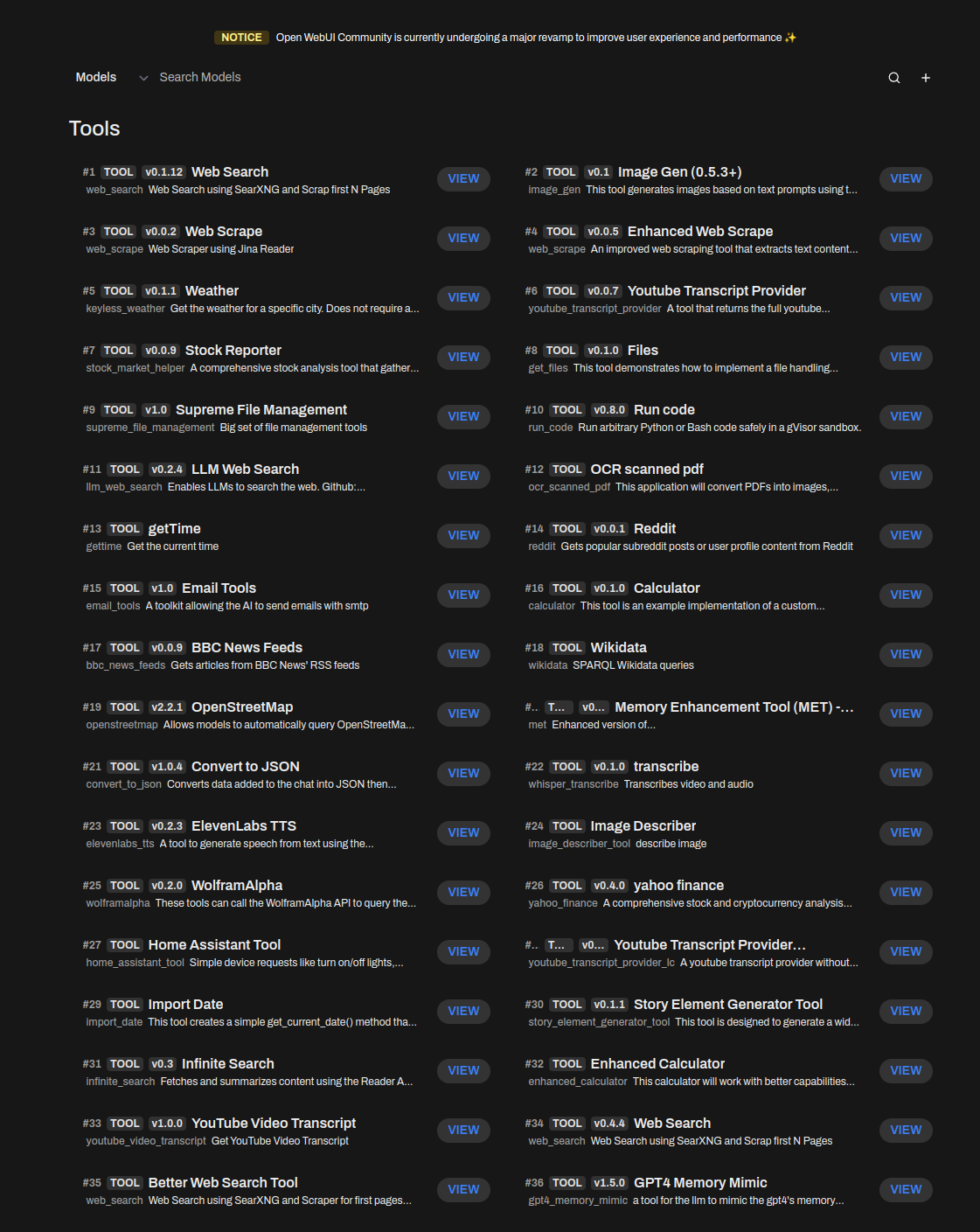

OpenWebUI

OpenWebUI

API接入:🟢

模型配置:🟢

部署方式:🔴

联网能力:🟢

知识库:🟢

数据同步:🟢

跨平台:🟢

插件:🟢

OpenWebUI也是一个跨端、支持插件、支持自定义模型供应商以及支持多格式知识库的ChatUI。

相比于LobeChat-Database,OpenWebUI的部署方式就简单很多很多了,据官方文档可知2行命令就可以搞定(python=3.11)。

pip install open-webui

open-webui serve不支持分支对话,但是支持知识库、联网和代码解释器。

除此之外,社区也提供了大量的插件和管道进行功能扩展。

模型供应商则需要自定义了。

以及支持多用户登录管理。

你可能要问:为什么这个应用在功能上比LobeChat要好,你为什么要把它放在第二呢?

这就不得不说它那耐人寻味的UX了...UI的使用体验上实在是一言难尽——有点像一个第一天学习UX的门外汉来做的UX。

所以才会把它放在第二,不过除此之外确实是目前在扩展性和功能性上最强大的开源ChatUI。

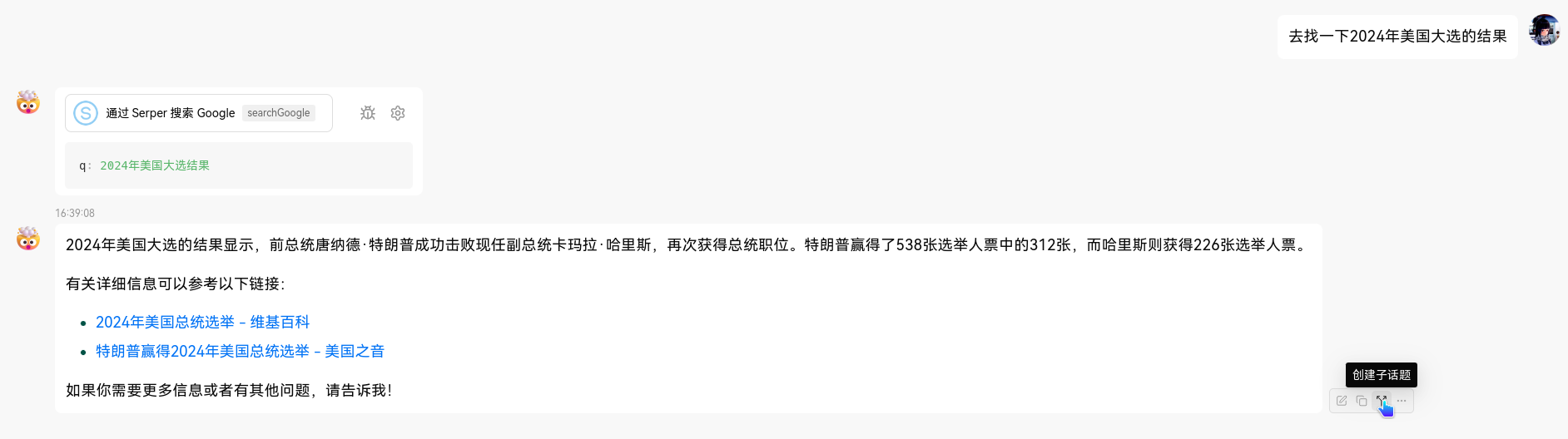

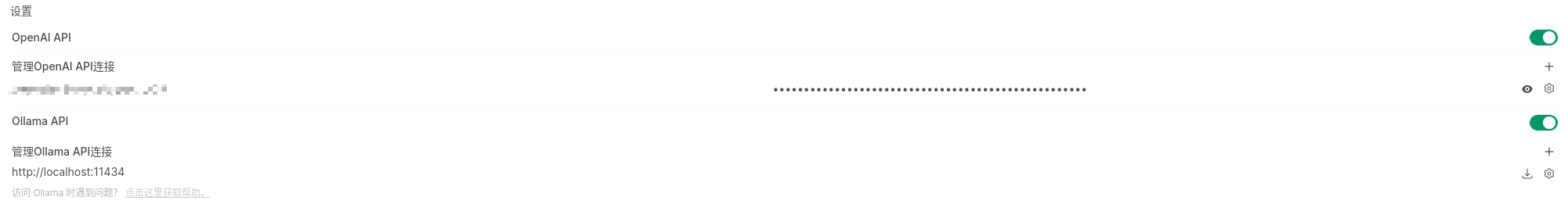

LobeChat

LobeChat

API接入:🟢

模型配置:🟢

部署方式:🟢

联网能力:🟢

知识库:🔴

数据同步:🔴

跨平台:🟢

插件:🟢

这里要注意一下,LobeChat和LobeChat-Database是两个东西,在功能上有一些区别,不过UI上是基本一样的。

这里我们可以针对这两者来仔细对比一下:

可以看到,Dtabase版本的支持数据库和多端同步数据,但是在部署的便利性上会差很多,除此之外就基本没有区别了。

因此,如果不需要知识库和多端同步数据的话,Lobechat就是在功能性、UI、部署便利性上综合下来最好的一个ChatUI。

也是支持分支对话、模型联网、自定义多个供应商和插件。

而且因为数据是存储在浏览器的本地数据库中的,因此本质上是一个纯静态页面,不需要后端的交互。

直接访问预览版选择对的供应商就可以使用了:

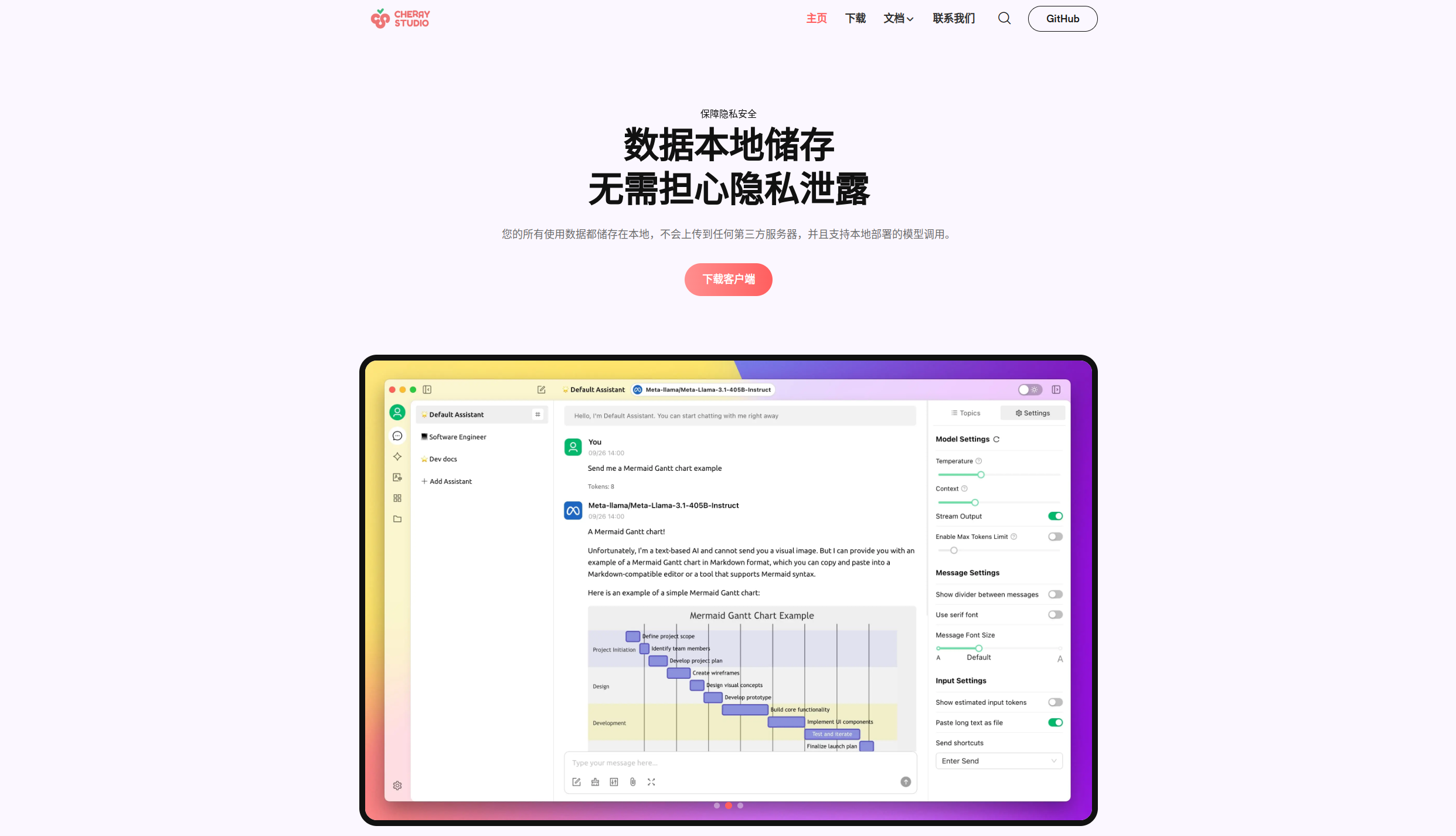

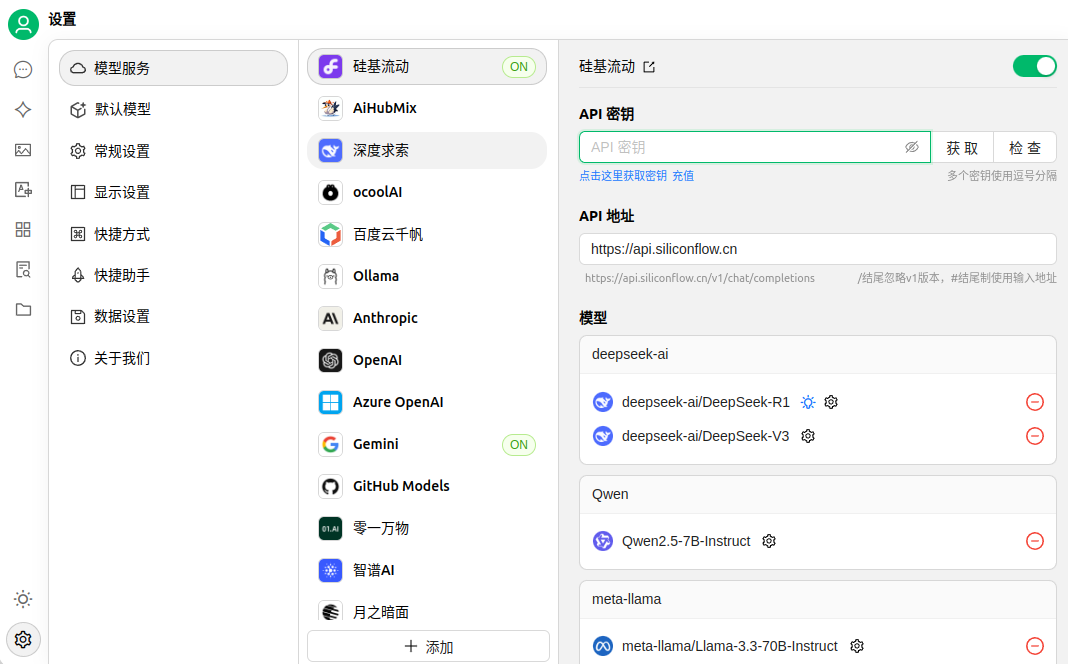

Cherry Studio

Cherry Studio

API接入:🟢

模型配置:🟢

部署方式:🟢

联网能力:🔴

知识库:🟢

数据同步:🟢

跨平台:🔴

插件:🔴

Cherry Studio是一个跨端的客户端应用,支持Windows、Linux和MacOS等桌面端,目前不支持移动端。

UI和UX做的挺不错,目前来说在UI和UX上我认为是市面上做的第二好的——最好的是LobeChat。

看着可能有点素,但UX比较舒服。

功能上,支持知识库和自定义大部分供应商的。

但是不支持联网和使用插件,这一点比较残念。

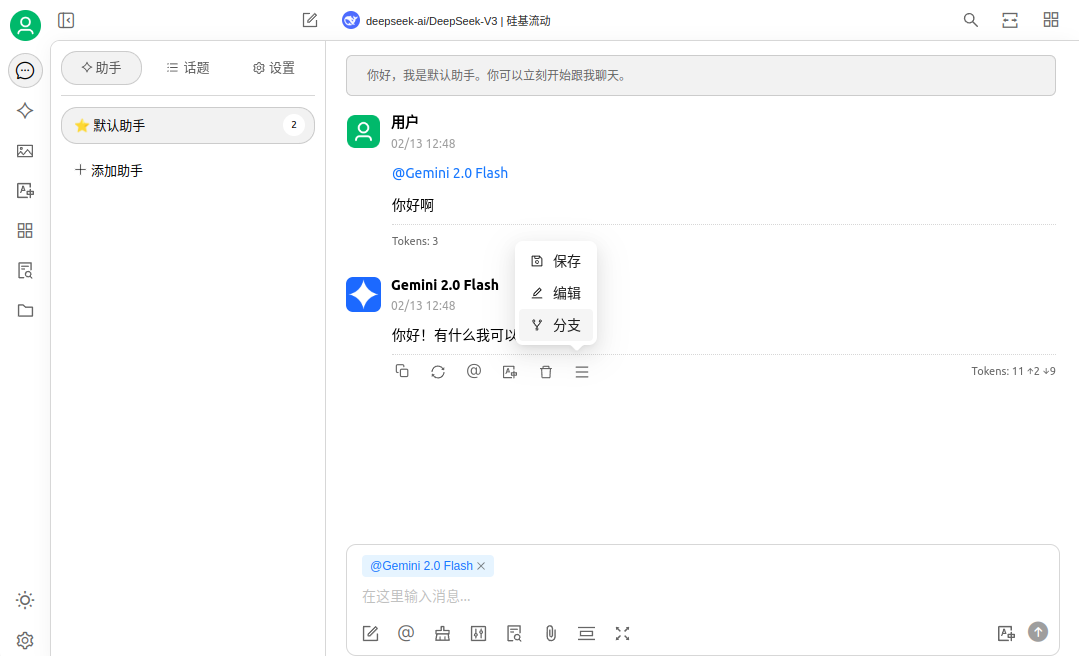

分支对话这个功能也是存在的,也是市面上少有的提供分支对话的ChatUI:

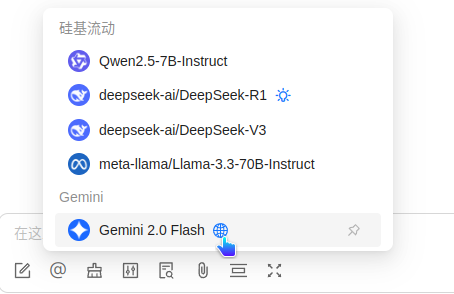

虽然可以看见Gemini 2.0 Flash可以联网,但是这个联网是谷歌自带的,并非应用提供的——也就是说仅在供应商那边可以联网的模型可以联网,其他均不能。

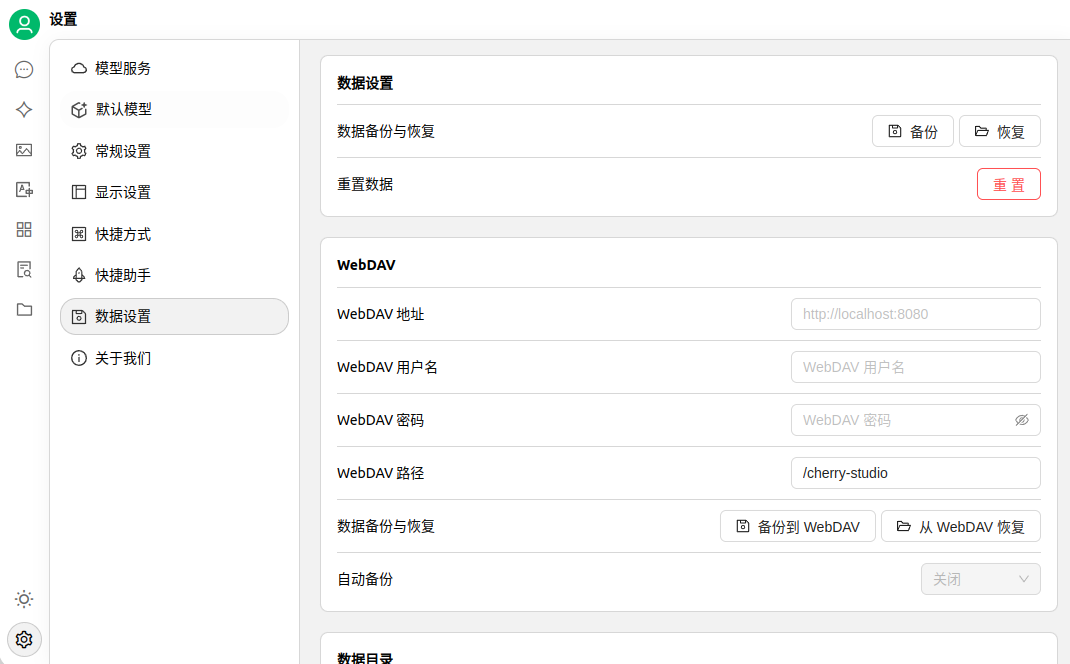

不过可以利用WebDav进行同步,也算是一个优点了:

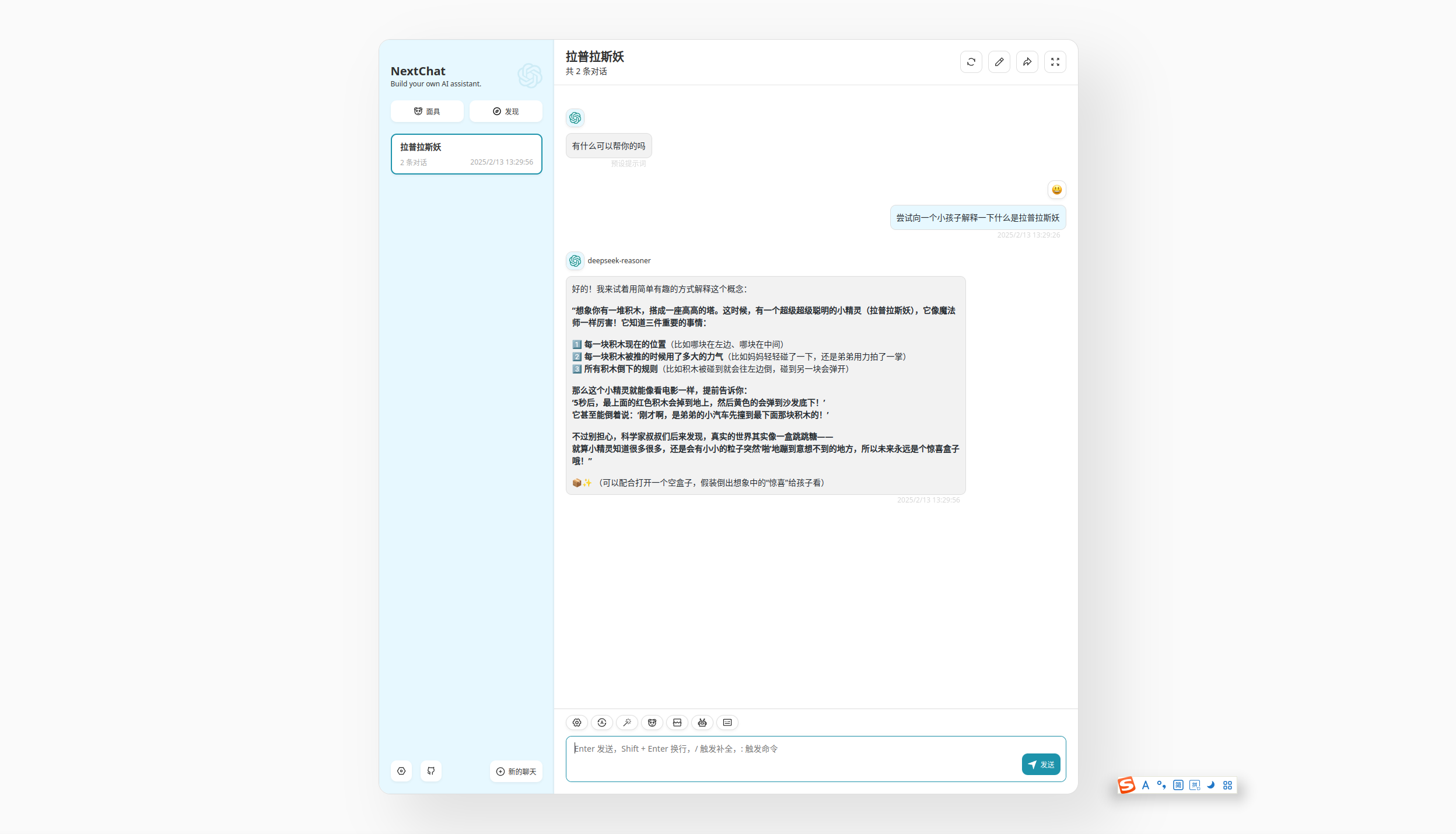

NextChat

NextChat

API接入:🔴

模型配置:🔴

部署方式:🟢

联网能力:🟢

知识库:🔴

数据同步:🟢

跨平台:🟢

插件:🟢

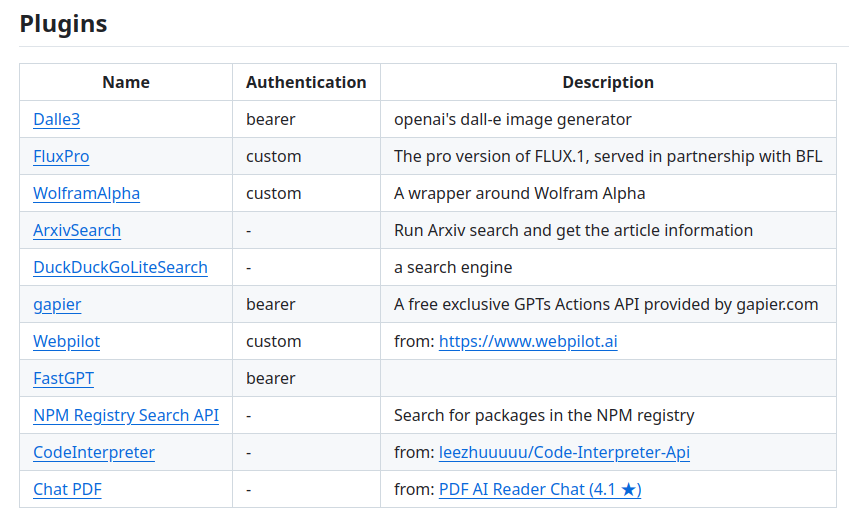

NextChat是一个跨端的ChatUI,支持插件、联网和自定义供应商。

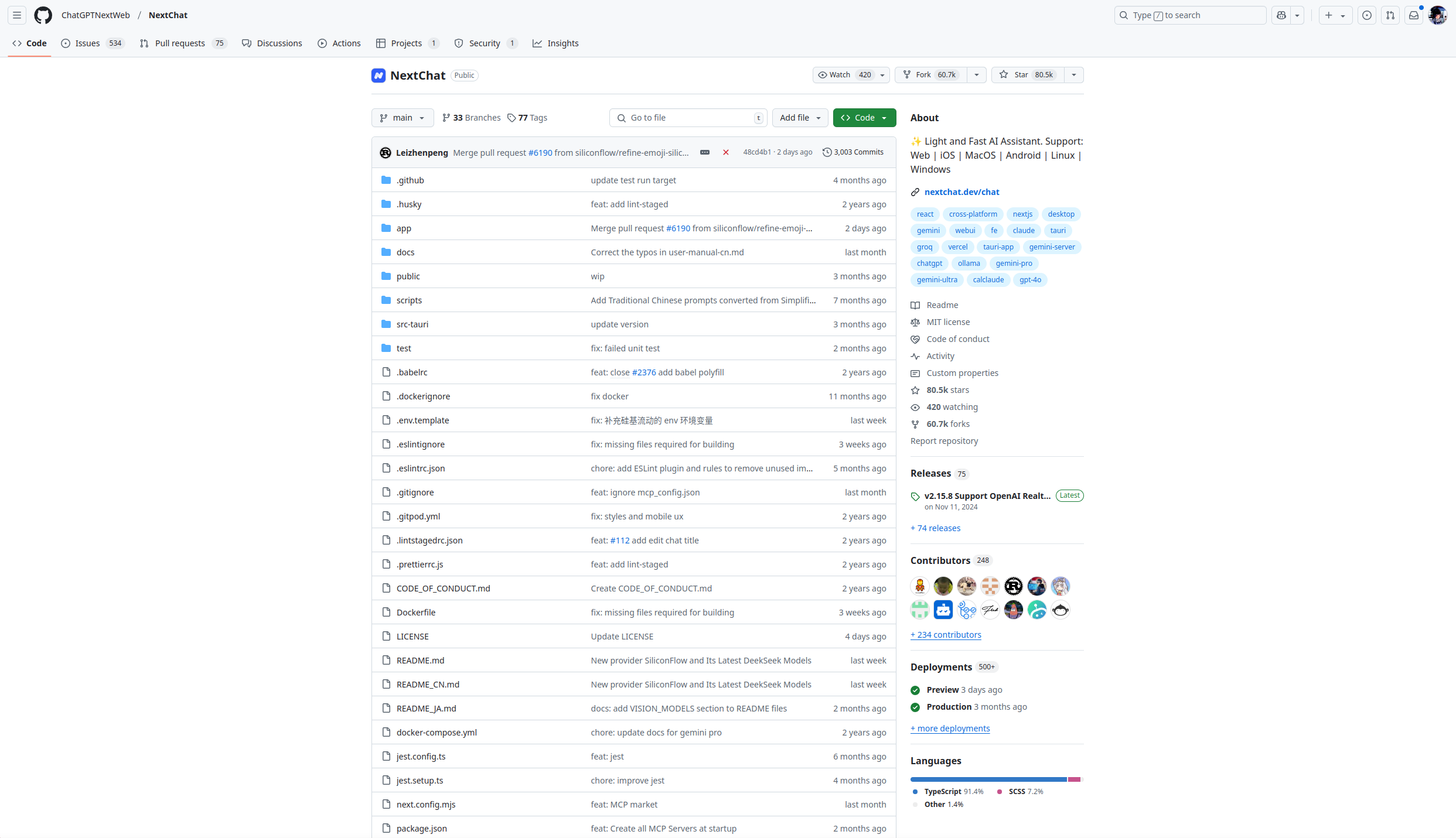

这个ChatUI是出现的最早的,也是传播的最广的一个ChatUI,到今天也依旧在进行更新,在GitHub上拥有80k的star,在ChatUI领域独领风骚。

它好就好在极其的轻量,坏也坏在极其的轻量。

本质上是一个纯静态的页面。

隔壁LobeChat虽然也是纯静态的页面——但它起码有Database版本的来支持后端啊。

正是因为轻量过头了,因此虽然支持插件,但由于其本身的扩展性比较低导致插件生态其实并不活跃。

支持WebDav同步,但比较离谱的是居然到今天还不支持Deepseek R1的思考过程展示。

在功能性上基本上就是只有纯粹的对话功能,不支持分支和知识库,联网功能也是由插件提供的做的不够好。

可以直接访问官方的预览版,在设置里选择供应商并填入key就可以使用:https://app.nextchat.dev/

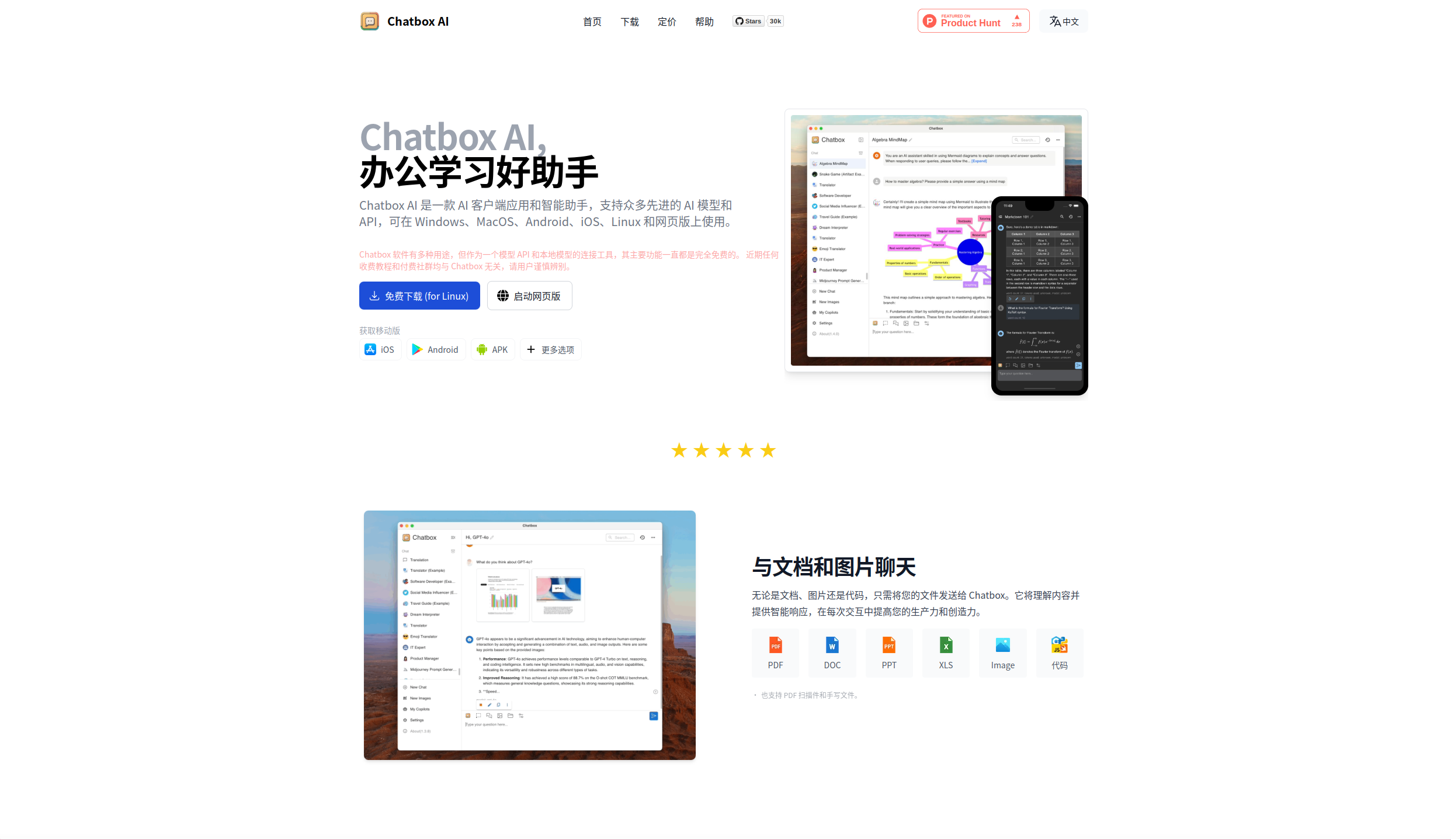

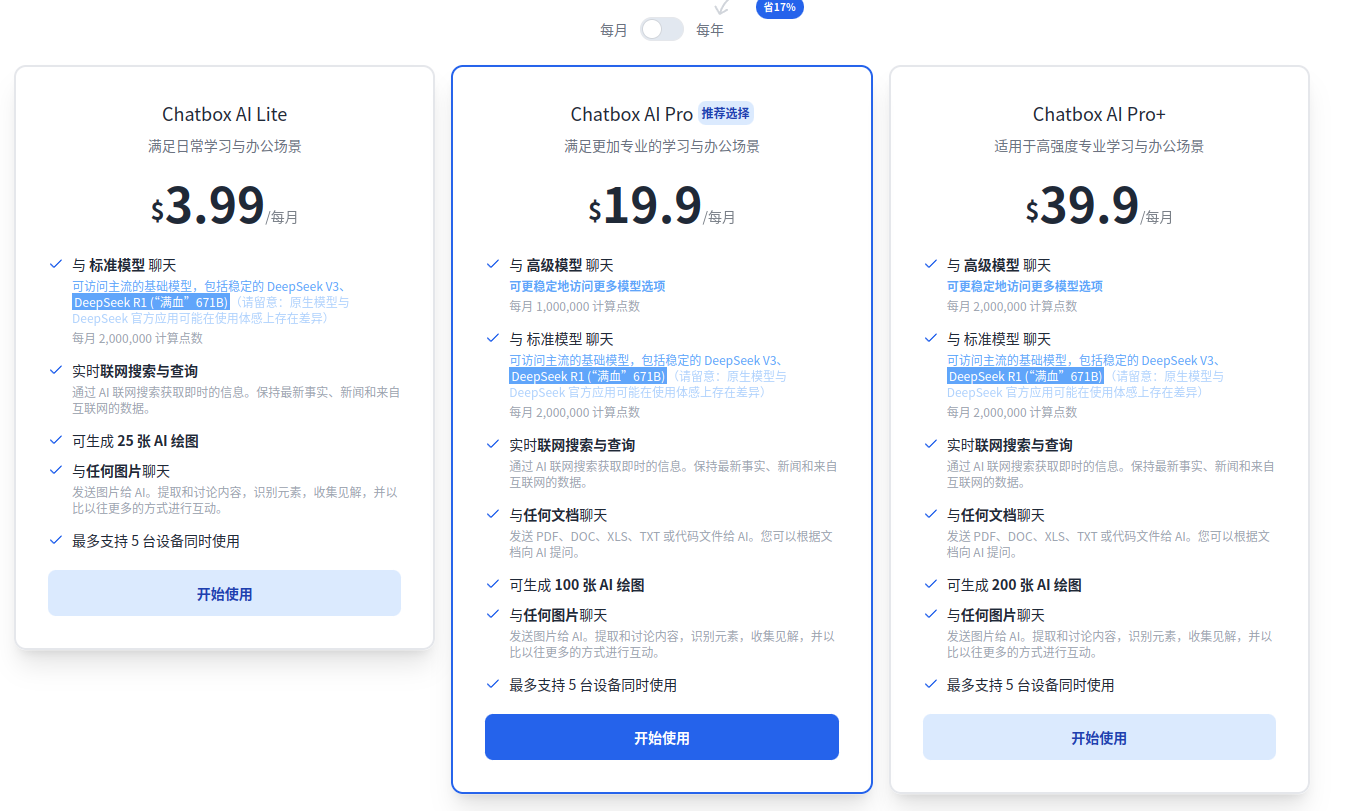

Chatbox

Chatbox

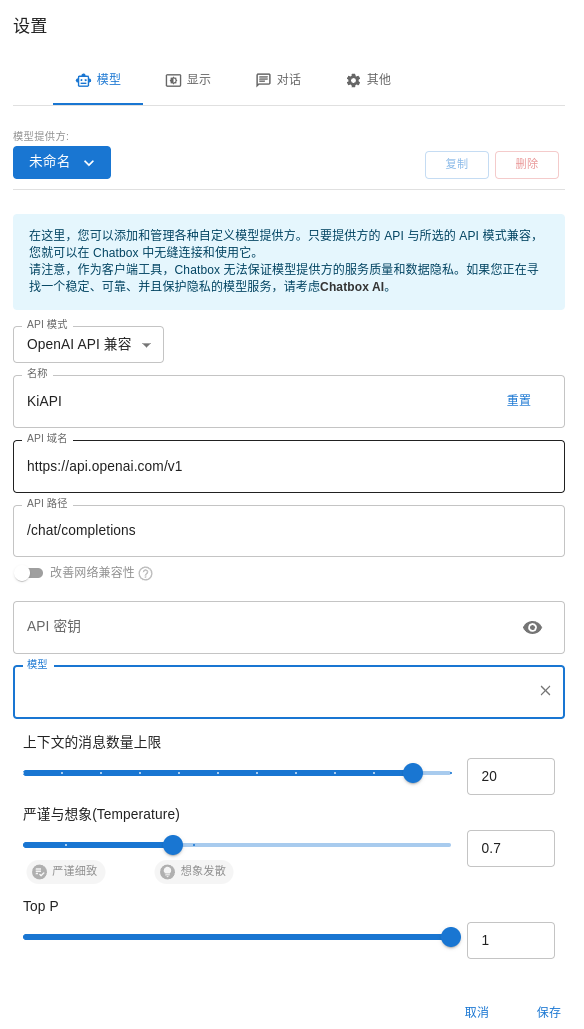

API接入:🔴

模型配置:🔴

部署方式:🟢

联网能力:🔴

知识库:🔴

数据同步:🔴

跨平台:🟢

插件:🔴

Chatbox是一个跨端、支持桌面端和移动端的ChatUI。

Chatbox也是一个出现的比较早的ChatUI了,早在2023年3月6日以前就开始立项了。

一年半过去了,现在的更新频率越来越低,功能上也有点跟不上现代的其他ChatUI了。

目前在功能上是只有基本的聊天功能的,不过倒可以上传文件。

但这个功能只有客户端支持,不支持网页端,以及是将文件整个喂给模型而不是向量化后再喂的,这一点上也是有点落后。

至于自定义模型供应商,也是有点麻烦的,还不支持自动获取模型,需要一个一个手动输入。

同步是没有的,想要这些功能只能去官网开一个Chatbox Cloud。

同样的,直接访问官方的网页预览版,选择供应商并填入key就可以使用:

如何选择

总结一下,可以根据下面的情况来进行选择,按优先程度进行排序:

没有其他杂七杂八的需求,只需要最简单普通的对话功能:

Lobechat:

https://chat-preview.lobehub.com/ ChatBox:

https://web.chatboxai.app/ NextChat:

https://app.nextchat.dev/

简单对话的功能的基础上,只需要知识库和上传文件这样的功能:

CherryStudio:

https://cherry-ai.com/ Open-WebUI:

https://docs.openwebui.com/ LobeChat-Database(不建议自己部署,我后面会写一篇关于如何部署LobeChat-Databse的文章,官方文档问题比较多):

https://lobehub.com/zh/docs/self-hosting/server-database ChatBox:

https://web.chatboxai.app/

在简单对话的功能基础上,只需要联网和支持插件:

Lobechat:

https://chat-preview.lobehub.com/ Open-WebUI:

https://docs.openwebui.com/ LobeChat-Database:

https://lobehub.com/zh/docs/self-hosting/server-database

我全都要,还需要同步:

Open-WebUI:

https://docs.openwebui.com/

LobeChat-Database(如果喜欢折腾可以优先选这个而不是Open-WebUI):

https://lobehub.com/zh/docs/self-hosting/server-database